引言

随着科技的飞速发展,数据的重要性日益凸显。204年新奥公司为了更好地把握市场动态,提高业务效率,决定开展一项数据整合方案设计工作。本文将详细介绍该方案的模拟版27.896,旨在为公司提供一套科学、高效的数据整合解决方案。

项目背景

新奥公司成立于1998年,是一家全球领先的综合性能源企业,业务涵盖石油、天然气、电力、化工等多个领域。随着公司业务的不断拓展,数据量呈爆炸式增长,数据整合工作显得尤为重要。

项目目标

本次数据整合方案设计的主要目标是构建一套高效、稳定的数据整合平台,实现数据的集中存储、统一管理和快速检索,为公司决策提供有力支持。

技术选型

在技术选型方面,我们综合考虑了多种因素,最终选择了Hadoop、Spark、Flink等大数据处理框架,以及MySQL、PostgreSQL、MongoDB等多种数据库系统。

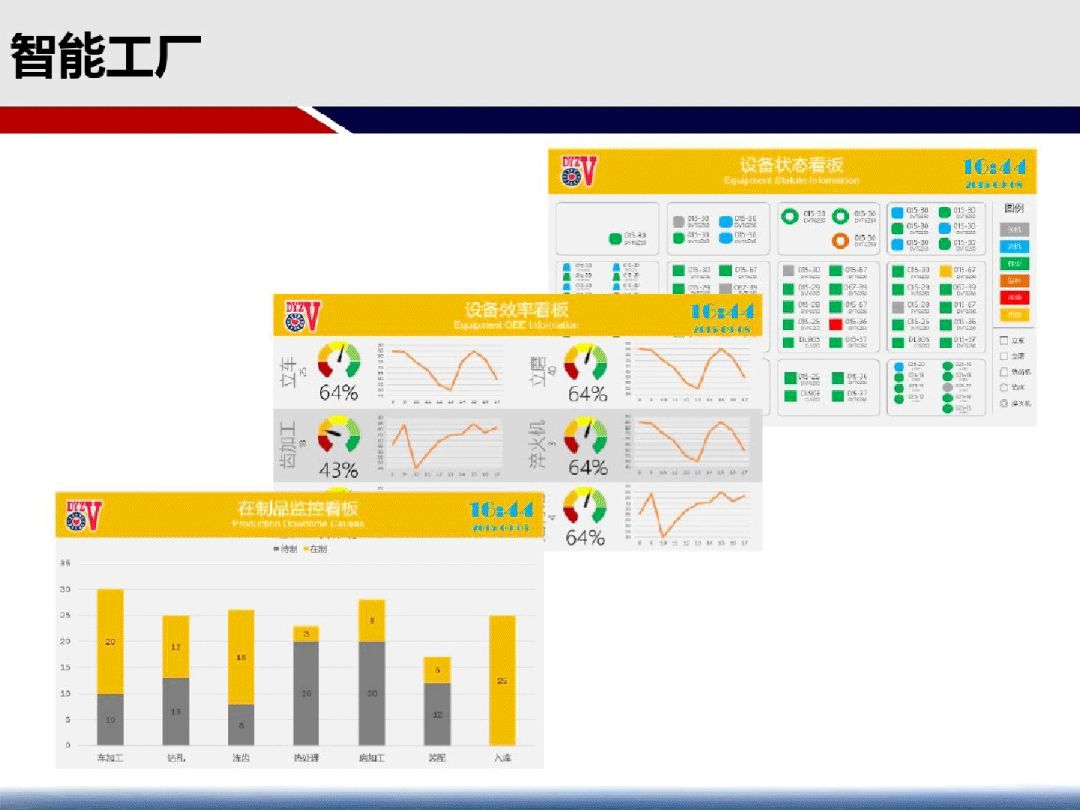

数据整合架构

数据整合架构主要包括数据采集、数据存储、数据处理和数据分析四个层次。数据采集层负责将各业务系统的数据实时或批量导入;数据存储层负责将数据存储到合适的数据库中;数据处理层负责对数据进行清洗、转换和聚合等操作;数据分析层负责对数据进行挖掘和分析,为决策提供依据。

数据采集

数据采集是数据整合的第一步,我们采用了多种技术手段,包括日志采集、API采集、数据库同步等,以确保数据的完整性和准确性。

数据存储

数据存储是数据整合的核心环节,我们采用了分布式存储系统HDFS,以实现数据的高可用性和高扩展性。同时,我们还采用了多种数据库系统,以满足不同业务场景的需求。

数据处理

数据处理是数据整合的关键环节,我们采用了Spark和Flink等大数据处理框架,以实现数据的高效处理和分析。同时,我们还采用了数据质量控制、数据治理等技术手段,以确保数据的准确性和一致性。

数据分析

数据分析是数据整合的最终目标,我们采用了多种数据分析工具和算法,包括机器学习、深度学习、关联规则挖掘等,以实现数据的深入挖掘和分析。

数据安全与隐私保护

在数据整合过程中,数据安全和隐私保护尤为重要。我们采用了多种技术手段,包括数据加密、访问控制、审计日志等,以确保数据的安全和隐私。

性能优化

为了提高数据整合平台的性能,我们采用了多种优化手段,包括数据压缩、索引优化、并行计算等,以实现数据的快速处理和分析。

监控与运维

为了确保数据整合平台的稳定运行,我们采用了多种监控和运维手段,包括实时监控、日志分析、故障排查等,以实现平台的快速响应和故障恢复。

总结与展望

通过本次数据整合方案设计,我们为新奥公司提供了一套高效、稳定的数据整合解决方案。未来,我们将继续优化和完善该方案,以更好地支持公司的业务发展和决策。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号